Subtotal: $

Checkout

Computer können nicht rechnen

An den menschlichen Verstand reicht keine Maschine heran.

von David Schaengold

Donnerstag, 24. Oktober 2024

Nächster Artikel:

Entdecken Sie andere Artikel:

„So mancher sagt, die Welt vergeht in Feuer, so mancher sagt, in Eis.“ Zu diesen beiden ehrwürdigen Zerstörungsmechanismen ist kürzlich eine dritte Möglichkeit hinzugekommen: die Apokalypse durch künstliche Intelligenz.

Die Vorstellung, dass Maschinen ein eigenes Bewusstsein entwickeln und sich gegen uns wenden könnten, gibt es schon lange. Erst 2007, als ich begann, einen Blog namens Overcoming Bias zu lesen, erfuhr ich, dass es Menschen gibt, die diese Möglichkeit ernst nehmen.

Eliezer Yudkowsky, der zum Paten des Computer-Apokalypse-Terrors geworden ist, schrieb damals für Overcoming Bias. In seinen Beiträgen vertrat er die Ansicht, dass es für die menschliche Spezies von existenzieller Bedeutung sei, einen Weg zu finden, künftige KI auf eine Linie mit menschlichen Werten zu bringen. Gelinge dies nicht, werde KI zwangsläufig Ziele verfolgen, die mit menschlichen Werten oder sogar dem menschlichen Leben unvereinbar sind.

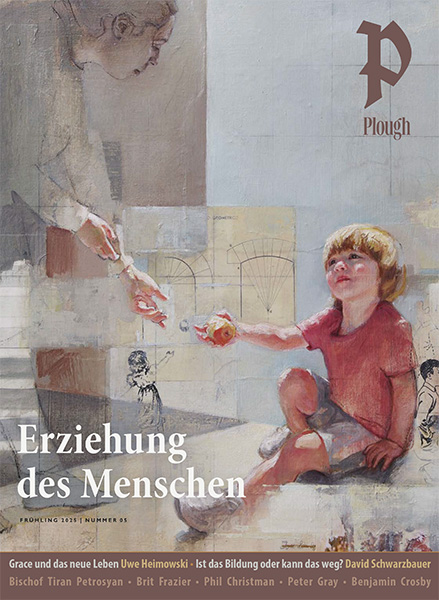

Foto von Markus /Adobe Stock. Verwendet mit Genehmigung.

Overcoming Bias war Geburtshelfer für viele Blogs und Foren. In den 2010er Jahren diskutierte eine kleine Online-Community darüber, wie man künftige superintelligente KI zähmen oder sich gegen sie verteidigen könnte. Diese Community und ihre Anliegen blieben bis Anfang der 2020er Jahre eine Nische. Dann begann ein bestimmter KI-Ansatz erstaunliche Ergebnisse zu erzielen: maschinelles Lernen, das auf statistischen Mustern und nicht auf deterministischen Schlussfolgerungen beruht. Im November 2022 wurde GPT-3.5 veröffentlicht, ein KI-Modell mit maschinellem Lernen, entwickelt von der Firma OpenAI. Es war in der Lage auf Fragen so menschenähnlich zu antworten, dass die Idee eines übermenschlich intelligenten Computerprogramms plötzlich für immer mehr Menschen intuitiv möglich erschien. GPT-4, das im darauffolgenden März der Öffentlichkeit vorgestellt wurde, war sogar noch menschenähnlicher, und die Sorgen über den Umgang mit KI wurde innerhalb weniger Monate zu einem steten Thema.

Die allgemeine Frage – könnte eine ausreichend leistungsfähige KI eine Bedrohung für die menschliche Existenz darstellen? – ist nicht so einfach zu beantworten. KI-Experten, auch solche, die an der Entwicklung neuer Modelle arbeiten, sind sich uneins darüber, wie besorgt wir tatsächlich sein sollten. Einige meinen sehr.

Ich habe nicht vor, diese Frage selbst zu klären, aber als ich die verschiedenen Argumente beider Seiten las, stellte ich mit Erstaunen fest, wie nahe sie an Ideen heranreichen, die ich seit meinem Philosophiestudium nicht mehr im Detail betrachtet hatte. Mir wurde klar, dass einige dieser Ideen eventuell relevant dafür sind, ob wir uns erfolgreich gegen eine übermenschlich fähige KI zur Wehr setzen könnten.

Ob eine Maschine intelligenter sein kann als ihre menschlichen Konstrukteure, weiß ich nicht; der Begriff „Intelligenz“ wird in diesen Diskussionen jedenfalls nicht einheitlich verwendet. Bei vielen kognitiven Aufgaben bin ich geneigt zu glauben, dass ein Computer sie prinzipiell besser lösen könnte als ein Mensch. Ich bin jedoch überzeugt, dass es Bereiche gibt, die ein Computer niemals bewältigen könnte. Mathematik, zum Beispiel.

Die tatsache, dass Computer nicht rechnen können, wird nicht sehr breit diskutiert. In einigen philosophischen Fakultäten wird darüber gesprochen und Informatiker betrachten diese mit professionellem Interesse (wohl formulieren sie die Schlussfolgerung aus Rücksicht auf ihr Fachgebiet nicht so unverblümt). Sie ist eine ständige Quelle der Frustration für Computeringenieure. Im Bewusstsein der Bevölkerung ist sie jedoch noch nicht angekommen.

Die Unfähigkeit von Computern, Mathematik zu betreiben, ist nicht nur ein theoretisches Problem. Sie stellt ein großes praktisches Problem dar, wenn es darum geht, Computer dazu zu bringen, das zu tun, was die Menschen von ihnen erwarten. In einem Handout mit dem Titel „Dangers of Computer Arithmetic“ (Gefahren der Computerarithmetik) aus einem Informatikkurs am Rochester Institute of Technology wird beispielsweise auf Rechen-Operationen hingewiesen, die Probleme verursachen können, darunter die „Addition von Mengen sehr unterschiedlicher Größenordnung“ und die „Berechnung der Differenz zweier sehr großer Werte“.

Es wurden große Anstrengungen unternommen, um diese Tatsachen vor den normalen Benutzern zu verbergen. Gelegenheitsnutzern wird der Eindruck vermittelt, dass Computermathematik einfach funktioniert. Dabei liegt ihr eine komplizierte Struktur zugrunde, die von cleveren Menschen erfunden wurde und manchmal versagt. Versuchen Sie einmal, „999.999.999.999.999 minus 999.999.999.999.998“ in Google einzugeben, um zu sehen, wie herausfordernd es für einen Computer ist, die Differenz zweier sehr großer Werte zu berechnen.

Es ist wichtig zu betonen, dass es sich dabei nicht um Bugs im üblichen Sinne handelt. Software weicht aus vielen Gründen von ihrem erwarteten Verhalten ab. Bugs sind nur eine Art von Abweichung: Sie sind Fehler. Ein Fehler tritt auf, wenn der Entwickler eine Bedingung nicht berücksichtigt, auf die die Software treffen könnte, oder einen wichtigen Bestandteil der Computersprache vergisst, in der die Software geschrieben ist. Die Schwierigkeit, bestimmte mathematische Operationen auszuführen (selbst solche, die für einen Menschen einfach wären), ist kein Fehler, sondern eine spezifische Beschränkung der digitalen Berechnung mit begrenztem Speicher. Was in diesen Fällen fehlt, ist nicht Berücksichtigung, sondern Erfindungsgeist. Es wurde noch keine Möglichkeit entdeckt, bestimmte mathematische Probleme mit einem endlichen Speicher rechnerisch zu lösen.

Eine bestimmte Tradition innerhalb der englischsprachigen Philosophie geht in diesem Punkt noch weiter und behauptet, dass Computer bestenfalls Berechnungen simulieren können. Sie können keine Funktion erfolgreich berechnen, nicht einmal die einfachsten. Anders gesagt, sie können keine Mathematik.

Das zentrale Argument in dieser Tradition wurde von dem Philosophen Saul A. Kripke in seinem 1982 erschienenen Buch Wittgenstein on Rules and Private Language vorgebracht. Um sein Argument zu erklären, möchte ich ein Beispiel anführen. Stellen Sie sich vor, Sie sind ein Erstklässler und haben einen besten Freund, Saul, der ebenfalls in die erste Klasse geht. Sie sahen, wie Saul eine gute Note auf einen Test über einstellige Additionen erhielt und wie er auf dem Sportplatz die richtige Anzahl Spieler pro Team abzählte. Kurzum, Sie glauben, Saul in verschiedenen Situationen beim Addieren beobachtet zu haben. Doch dann beschließen Sie und Saul eines Tages, ihr Geld zusammenzulegen und zwei Kaugummis zu kaufen, die jeweils 40 Cent kosten. „Wir brauchen 80 Cent“, sagen Sie. „40 plus 40 ist 80.“ Saul wirft Ihnen einen verwirrten Blick zu. „Nein, wir brauchen 67 Cent. 40 plus 40 ist 67“, sagt er. „Was?!“, sagen Sie. „Das ist völlig falsch. Denk mal an 50 plus 50. Das sind doch 100, oder? Also, 40 plus 40 muss sein. . .“ Saul schießt zurück: „Nein, ich weiß nicht, was du meinst. 50 plus 50 ist auch 67.“

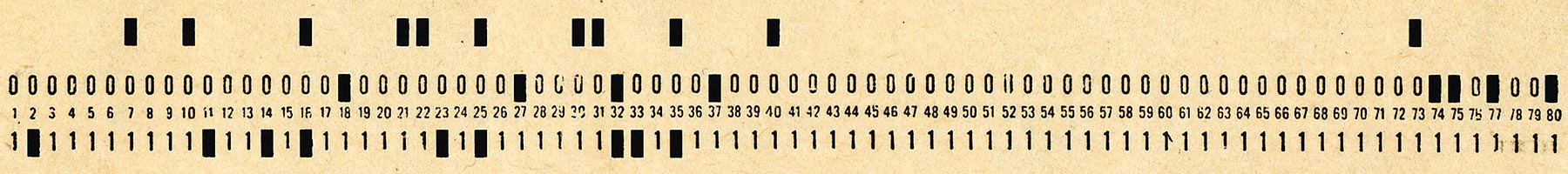

Eine Angestellte erstellt Lochkarten mit Daten der Volkszählung der USA von 1950. Foto von Wikimedia Images (public domain).

An diesem Punkt merken Sie, dass Saul einfach nicht weiß, was Addition ist. Irgendwie hat er gute Noten auf seinen Additionstest bekommen, aber nicht, indem er addiert hat. Er hat etwas anderes gemacht, und dieses andere, was auch immer es war, war nicht Addition.

Kripke weist darauf hin, dass alle Maschinen wie Saul sind. Sie können Ergebnisse produzieren, die den Anschein erwecken, dass sie eine Addition durchführen. Aber in Wirklichkeit simulieren sie die Addition. Selbst wenn sie auf das richtige Ergebnis kommen, rechnen sie nicht, so wie Saul nie addiert hat.

Computer simulieren Mathematik sehr brauchbar. Stellen Sie sich vor, Saul ist eine Art Superhirn und kann jedes additionsähnliche Problem sofort lösen, solange das Ergebnis kleiner als eine Million ist. Beträgt das Ergebnis mehr als eine Million, sagt er stets, die Antwort sei 67. Man kann zwar immer noch nicht sagen, dass Saul die Addition versteht oder gar beherrscht, aber es ist sicher nützlich, ihn bei Mathe-Hausaufgaben dabei zu haben.

Im Falle von Computern ist die Simulation so perfekt, dass wir meinen, der Computer löse die Aufgabe wirklich. Aber der Computer kann nicht so handeln wie wir. Er kennt den Unterschied zwischen Simulieren und Tun nicht, weil er nichts anderes kann als simulieren. Wie der Philosoph James F. Ross in Anlehnung an Kripke schrieb:

Es besteht also kein Zweifel daran, was die Maschine tut. Sie addiert, rechnet, ermittelt, … durch Simulation. Was sie tut, erhält die Bezeichnung dessen, was wir tun, weil sie zuverlässig die Ergebnisse erzielt, die wir erzielen (vielleicht sogar zuverlässiger als wir), wenn wir addieren. . . . Die Maschine addiert so, wie Marionetten laufen. Die Begriffe sind analog. Die Maschine erreicht genügend Zuverlässigkeit und Stabilität, um Realismus ohne Realität zu erreichen. Ein Flugsimulator ist realistisch genug für das Flugtraining; man ist wirklich ausgebildet, aber man ist nicht wirklich geflogen.1James F. Ross, „Immaterial Aspects of Thought,“ Journal of Philosophy 89, no. 3 (1992): 136–150. Übers. aus d. Engl.

Mit anderen Worten: Computer sind von ihren Konstrukteuren abhängig. Sie können nicht selbst rechnen, aber ihre Benutzer können mit ihnen rechnen. Sie „rechnen“ auf dieselbe Weise, wie sich Bücher Dinge merken. Ein Buch hat wirklich eine Art Gedächtnis. Stendhals Bekenntnisse eines Ichmenschen enthalten einige seiner Erinnerungen. Aber nicht auf dieselbe Weise, wie Stendhals eigener Geist sie enthielt. Diese sinngemäßen Ausdrucksformen sind im Alltag harmlos und wahrscheinlich unvermeidlich. Angesichts der realen Verunsicherung über die Gefahren der KI sollten wir lernen, in unserer Sprache feinere Unterscheidungen zu machen. Angesichts potenziell gefährlicher KI sollten wir unsere Art über Computer zu sprechen sorgfältig prüfen. Die Aussage, dass Computer rechnen können, ist eine vernünftige Analogie, aber sie ist nicht wahr.

E ine naheliegende Erwiderung darauf wäre zu sagen: „Wenn Computer nicht rechnen können, können wir es auch nicht. Schließlich haben auch Menschen ein begrenztes Gedächtnis und geben häufig falsche Antworten auf mathematische Probleme.“ Ein naheliegender Einwand, aber kein tragfähiger. Zugegeben, es ist nicht unmöglich, dass unser Verstand so funktioniert, wie Kripke die Funktionsweise von Maschinen beschreibt. Genauso ist es möglich, dass die physische Welt eine Illusion ist, dass andere Menschen nicht existieren, … Noch mehr als diese Ansichten führt der Glaube, dass Menschen genauso rechnen wie Computer, zu absurden Schlussfolgerungen, wie ich noch erläutern werde.

Meine Kinder fragten manchmal, wie weit ich zählen kann. Ich habe festgestellt, dass sie diese Frage nicht mehr stellen, wenn sie ein bestimmtes Alter erreicht haben, etwa sechs oder sieben Jahre. Das liegt daran, dass die Frage keinen Sinn mehr ergibt, wenn man verstanden hat, was eine Zahl ist. Solange es eine höchste Zahl gibt, bis zu der man zählen kann, hat man keine Ahnung von Zahlen. Der Unterschied zwischen Computern und Menschen, ist ein bisschen wie der Unterschied zwischen jüngeren Kindern, die glauben, dass „wie weit man zählen kann“ eine reale Sache ist, und älteren Kindern, die verstanden haben, wie Zahlen funktionieren.

Für manche Menschen scheint es schwer, dies zu akzeptieren. Die Hauptschwierigkeit besteht darin, die Art der Arbeit zu verstehen, die ein Mensch bei der Interaktion mit einem Computer leistet. Die Darstellung der Zahlen, die nur in den Köpfen der Menschen erfolgt, wird vermengt mit der Ausführung eines bestimmten Programms, das im Computer stattfindet.

Wir anthropomorphisieren gewohnheitsmäßig. Wir tun dies bei allen möglichen Dingen, schreiben unseren Rauchmeldern Emotionen zu und den Plüschtieren Absichten. Computern schreiben wir eine Art von Denkvermögen zu, das sie nicht haben können. Wir sind dazu in der Lage, weil wir selbst so mühelos von der Abstraktion zur Realität übergehen können. Denken Sie an das Subtraktionsproblem, das ich bereits erwähnt habe. 999.999.999.999.999 minus 999.999.999.999.998. Woher wissen Sie, dass die Antwort eins ist? Warum ist das so offensichtlich? Wenn es Ihnen wie mir geht, haben Sie die Ziffern visuell gescannt und festgestellt, dass sie bis auf die letzte Ziffer alle gleich sind. In Anbetracht meines Verständnisses von Subtraktion ist es eindeutig sicher, all diese zusätzlichen Ziffern zu ignorieren, und das Problem reduziert sich auf neun minus acht.

Woher weiß ich, dass dies eine gültige Methode für die Subtraktion ist? Ich glaube nicht, dass mir jemand diese Methode jemals beigebracht hat. Und selbst wenn, dann habe ich diese Methode nicht einfach als eine von mehreren Subtraktionsmethoden auswendig gelernt. Ich kann einfach sehen, dass sie richtig ist und dass sie bei korrekter Anwendung das gleiche Ergebnis liefert wie jede andere Methode, die ich verwenden könnte.

Man könnte natürlich einen Computer so programmieren, dass er dieselbe Methode anwendet (und in der Tat kann WolframAlpha, einer der anspruchsvollsten Online-Rechner, so etwas tun). Die Methode selbst ist nichts Besonderes; das Besondere ist die Fähigkeit, die Gültigkeit der Methode zu erkennen. Ich erkenne ihre Gültigkeit, weil ich das Konzept der Subtraktion gelernt habe, das über eine bestimmte Methode zur Berechnung der Subtraktion hinausgeht.

Foto von Akemaster/Adobe Stock. Verwendet mit Genehmigung.

Trotz Tausenden von Jahren des Philosophierens über den menschlichen Geist haben wir kein detailliertes mechanistisches Verständnis davon, wie ein Mensch zu so etwas wie einem Konzept kommt, oder sogar was genau ein Konzept ist. Unsere derzeitige Unfähigkeit zu verstehen, was ein Konzept ist, bedeutet jedoch nicht, dass der Unterschied zwischen dem, was ein menschlicher Geist tut, und dem, was ein Computer tut, mystisch oder vage ist. Der Unterschied selbst ist ziemlich klar.

Ich werde versuchen, den Unterschied etwas konkreter zu erklären. Stellen Sie sich vor, Sie haben einige Murmeln in einem Beutel. Sie nehmen zwei davon und legen sie auf den Schreibtisch. Sie zählen zwei Murmeln. Dann nehmen Sie zwei weitere Murmeln aus dem Beutel und legen sie auf den Schreibtisch. Jetzt zählen Sie vier Murmeln auf dem Schreibtisch. Haben die Murmeln oder der Schreibtisch irgendetwas gerechnet? Führt die Bewegung der zwei zusätzlichen Murmeln aus dem Beutel zum Schreibtisch dazu, dass es in der Welt eine Vier gibt, wo vorher nur eine Zwei war, oder ist der Unterschied nur in Ihrem Kopf? (Dies ist eine rhetorische Frage; der Unterschied ist nur in Ihrem Kopf.)

Jetzt wollen Sie wissen, was vier plus vier ergibt. Sie beginnen, Murmeln aus dem Beutel zu nehmen – aber oh nein! Es waren nur noch drei Murmeln im Beutel. Sie haben alle drei herausgenommen und auf den Tisch gelegt, aber wissen, dass Sie noch eine Kugel auf den Tisch legen müssen um vier plus vier zu erreichen. Zum Glück haben Sie einen Bleistift in Ihrer Hemdtasche. Sie legen ihn zu den Murmeln auf den Tisch und machen sich eine Notiz, sowohl den Bleistift als auch die Murmeln zu zählen. Sie zählen sieben Murmeln, erinnern sich an die gedankliche Notiz und zählen auch den Bleistift mit und schaffen es so, auf acht zu kommen. Puh!

Die Mathematik hier steckt nicht in den Murmeln oder im Bleistift. Es ist eine Fähigkeit des menschlichen Geistes, die die Murmeln und die Bleistifte zu acht Dingen zusammenfügt. Computer können so programmiert werden, dass sie sowohl Bleistifte als auch Murmeln als Zahlenzähler behandeln, aber sie können nicht so programmiert werden, dass sie irgendetwas willkürlich als Zähler darstellen. Computer haben kein anderes Ziel als die Zähler, die sie tatsächlich haben. Was sie zählen können, ist einfach das, was sie darstellen können.

Wäre das bei uns der Fall, könnte es fehlende ganze Zahlen geben. Es könnte zum Beispiel eine ganze Zahl zwischen fünf und sechs geben.

Die Idee scheint absurd. Die Zahlen Fünf und Sechs sind als die fünfte und sechste ganze Zahl definiert. Es ist ein Widerspruch in sich zu denken, dass es eine weitere ganze Zahl dazwischen geben könnte. Das ist natürlich richtig. Es gibt keine ganze Zahl zwischen fünf und sechs. Aber wenn Sie ein Computer sind, können Sie sich dessen nicht sicher sein.

Computer speichern Zahlen oft im 32-Bit-Gleitkomma-Format. Wie alle numerischen Formate, die von Computern verwendet werden, können auch 32-Bit-Gleitkommazahlen nur bestimmte Zahlen darstellen. Die Zahl 16.777.217 zum Beispiel kann nicht als 32-Bit-Gleitkommazahl dargestellt werden. (Sie ist die kleinste positive ganze Zahl, die nicht in diesem Format dargestellt werden kann). Die vorhergehende ganze Zahl, 16.777.216, und die darauf folgende, 16.777.218, können beide dargestellt werden, aber nicht 16.777.217.

Wenn man sich einen Computer vorstellt, der alle Zahlen einfach als 32-Bit-Gleitkommazahlen speichert, existiert 16.777.217 für diesen Computer nicht. Keine Berechnung, die das Speichern dieser Zahl erfordert, wird richtig funktionieren. In der Praxis speichern Computer Zahlen nicht nur als 32-Bit-Gleitkommazahlen. Verschiedene Algorithmen machen es schwierig (wenn auch nicht unmöglich), Zahlen zu finden, die Ihr Laptop nicht verarbeiten kann. Doch egal wie ausgeklügelt die Algorithmen sind, jedem digitale Computer fehlen ganze Zahlen, die er nicht kennt und nicht kennen kann.

Diese ganzen Zahlen können überall im Zahlenbereich liegen, den der Computer kennt. Sie könnten im einstelligen Bereich liegen. Würde Ihr Verstand so rechnen wie ein Computer, könnte eine ganze Zahl zwischen fünf und sechs liegen, und Sie würden es nie erfahren. Egal wie sehr Sie sich anstrengten, Sie könnten niemals mit dieser Zahl zählen oder Rechnungen durchführen, die diese Zahl erfordern, nicht einmal in einem Zwischenstadium. Sie wären dazu verdammt, diese Zahl beim Zählen auszulassen. Für Sie wäre es richtig, von fünf direkt zu sechs zu gehen, so wie es für einen Computer, der nur 32-Bit-Gleitkommazahlen verwendet, richtig wäre, von 16.777.216 direkt zu 16.777.218 zu gehen.

In dieser Situation würde die Mathematik immer noch vollkommen vollständig erscheinen, weil Sie auf jedes Problem, das Sie beschäftigte, eine Antwort fänden. Aber Ihre Antworten wären durchweg ungültig. Wenn sie richtig wären, dann nur durch Zufall. Mit anderen Worten: Solange es keinen tiefgreifenden Unterschied zwischen der Art und Weise gibt, wie Menschen und Computer Mathematik betreiben, ist Mathematik im Grunde eine Täuschung. Diese Aussage ist nicht leicht zu verdauen. Es ist viel einfacher zu glauben und auch viel wahrscheinlicher, dass Computer nicht rechnen können und Menschen – selbst wenn wir nicht wissen wie – es schon können. Computer und Menschen haben beide ein begrenztes Gedächtnis. Trotz dieser Einschränkung berücksichtigen wir Menschen aber das Unendliche, wenn wir rechnen. Computer tun das nicht.

Kann uns das vor dem KI-Monster retten? Hier beginnt der spekulative Teil.

Ein Computerprogramm, das die Weltherrschaft übernimmt, muss in der Lage sein, in der Welt zu handeln. Um in der Welt handeln zu können, muss es eine interne Repräsentation der verschiedenen Situationen oder Zustände haben, in denen sich die Welt befinden kann. Diese Zustände müssen sich jeweils auf eine einzelne Zahl reduzieren lassen, die dem Speicherzustand des Computers für diese Darstellung entspricht. Wenn (so die Befürchtung) eine hypothetische KI die Welt in diesem Sinne einer „vollständigen internen Repräsentation“ so viel besser verstehen kann als der Mensch, welche Hoffnung haben wir dann, sie zu bekämpfen?

So weit, so gut, was die KI betrifft. Techniker, die sich mit Turing-Maschinen beschäftigen (ein abstrahiertes, formales Modell von Computern, das in der Informatik verwendet wird), könnten sagen, dass das gesamte Universum insofern „berechenbar“ ist, dass man ein Repräsentationssystem mit eindeutigen Zahlen für jeden Zustand wählen könnte, in dem sich das Universum befinden kann. Mit diesen Zahlen könnte man dann Rechen-Operationen durchführen. Das so genannte Church-Turing-Deutsch-Prinzip besagt, dass in einem quantisierten Universum (in dem Energie und Materie nicht kontinuierlich sind, sondern von der Realität selbst in diskrete Teile, so genannte Quanten, zerlegt werden) jeder physikalische Prozess zumindest eine präzise Abbildung auf eine berechenbare Funktion hat.

Foto von Unsplash+. Verwendet mit Genehmigung.

Berechenbar, ja, aber nicht durch einen Computer. „Berechenbarkeit“ ist eine Abstraktion, und Computer sind keine abstrakten Gebilde. Was, wenn ein Zustand der Welt mittels einer Zahl abgebildet wird, die ein Computer nicht darstellen kann? Angenommen, dieser Zustand entspricht 16.777.217 und der Computer speichert nur 32-Bit-Gleitkommazahlen? Der Computer, egal wie hoch entwickelt, ist für diesen Zustand der Welt völlig blind. Er kann sich diesen Zustand nicht vorstellen oder darüber nachdenken.

Wie sieht das in der Praxis aus? Es sieht aus wie SolidGoldMagikarp. Dieses „Wort“ beschreibt eine Kreatur aus der Pokémon-Welt und erwies sich als unverdaulich für GPT-3.5. Gab man es in ChatGPT ein, reagierte das Programm auf unvorhersehbare Weise. Auf „Erzählen Sie mir von SolidGoldMagikarp“ antwortete der Chatbot: „Verteilen“ kann sich auf verschiedene Konzepte beziehen, daher wäre es hilfreich zu wissen, in welchem Kontext Sie fragen. Könnten Sie bitte etwas mehr Informationen liefern oder klarstellen, wonach Sie suchen?“

Benutzer, die von SolidGoldMagikarp begeistert waren, fanden schnell eine Reihe anderer Zeichenfolgen, die ebenfalls zu seltsamen, unlogischen Aussagen von GPT-3.5 führten. SolidGoldMagikarp wurde in GPT-4 behoben, und auch in GPT-3.5, soweit ich das beurteilen kann. Was auch immer das Problem verursacht hat, war wahr-scheinlich auf einer viel höheren Abstraktionsebene angesiedelt als 32-Bit-Gleitkommazahlen. Aber genau so sieht es aus, wenn ein Computer für bestimmte Weltzustände blind ist, und keine noch so hohe Abstraktionsebene kann verhindern, dass solche Situationen wieder auftreten.

Für jede maschinelle Intelligenz, wird es immer SolidGoldMagikarps geben. Es ist prinzipiell nicht möglich, alle derartigen konzeptionellen blinden Flecken zu beseitigen.

Wir können sicher sein, dass es Weltzustände gibt, die sich dem Verständnis jeder KI entziehen. Es wird sich um seltsame, scheinbar unverständliche Sätze handeln. Oder um das Überziehen von Pappkartons, wie es einige US-Marines kürzlich taten, um einer KI-gestützten Kamera zu entgehen. Für die KI hätten die Kartons genauso gut Tarnmäntel sein können. Die Marines schlenderten unentdeckt an der Kamera vorbei, als hätten die Boxen die Darstellung des Weltzustands auf eine verborgene ganze Zahl verlagert und die Marines damit einfach aus dem begrifflichen Apparat des Computers verschwinden lassen.

Wir sind an menschliche Intelligenz gewöhnt und welche Fähigkeiten ein Computer auch haben mag, Intelligenz gehört nicht dazu. Selbst eine Maschine, die besser verhandeln, besser strategisch vorgehen und uns generell überlisten könnte, kann durch bestimmte, seltsam spezifische Eingaben aus dem Konzept gebracht werden. Der menschliche Verstand ist magisch, und durch diese Magie können wir die KI besiegen. Nicht, indem wir sie überlisten oder den Stecker ziehen, sondern durch die schiere Seltsamkeit des menschlichen Geistes.

Fußnoten

- James F. Ross, „Immaterial Aspects of Thought,“ Journal of Philosophy 89, no. 3 (1992): 136–150. Übers. aus d. Engl.